GoogleがGemini 3と同時期にリリースしたAIコードエディタのAntigravity(アンチグラビティ)について特徴を整理しました。

並列タスク実行と独立したAgent Manager

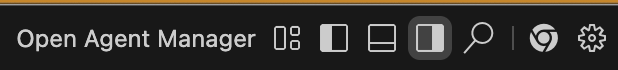

複数のAgentを管理できるAgent Managerが存在します。エディタの右上から独立したウインドウで開くことが可能です。

Start conversationからAIとコミュニケーションを取ることが可能です。ここで依頼先?として、PlaygroundとWordspaceがありますが、Playgroundはチャットだけでコミュニケーションを取るイメージで、Workspaceの方は具体的にファイル操作などもしてもらえる違いかなと思います。

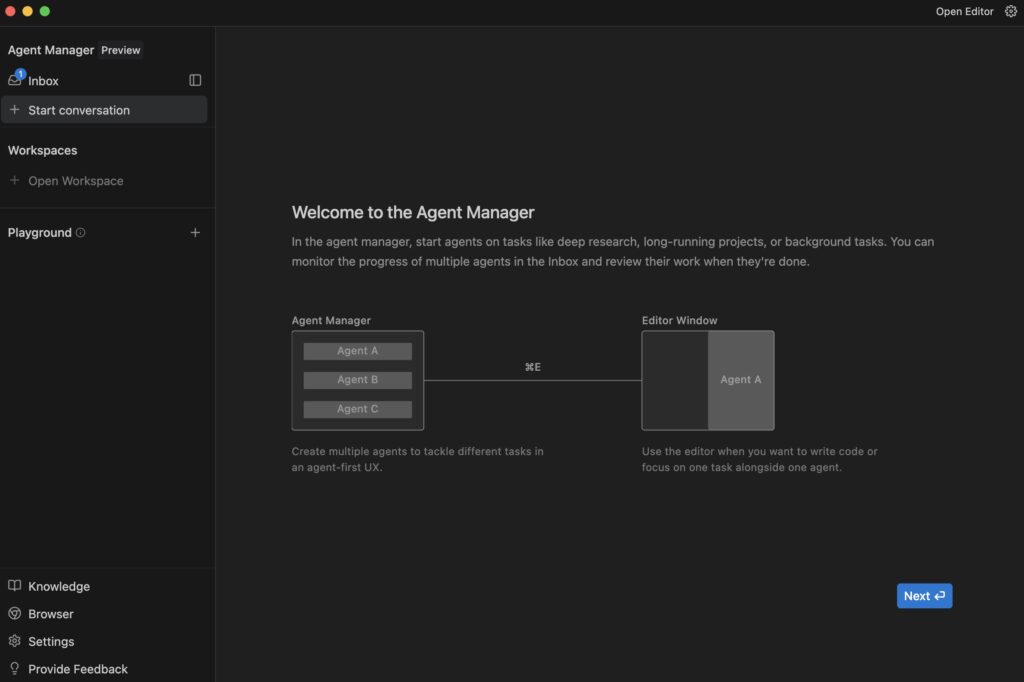

すごく雑に依頼してみました。以下のように「Agent Manager」のInboxで複数の依頼した内容が動いていることが確認できます。

Wordspaceで作成すると、ファイルとコードを生成してくれました。

「Antigravity」は並列したタスク実行に強い特徴があるようです。複数のタスクを動かしつつ、それらのタスクの動きはAgent Managerで一元的に管理することが可能です。

AIエージェントはブラウザを操作してテストができる

ブラウザが統合されていることは「Antigravity」の特徴かなと思います。AIエージェントはChromeブラウザを操作することができます。

Browser Use

The Agent is able to use Chrome to navigate to pages and interact with them, enabling browser-in-the-loop testing of its own code.

(日本語訳)

ブラウザの使用エージェントは Chrome を使用してページに移動し、ページを操作できるため、自身のコードのブラウザインザループテストが可能になります。

引用:https://antigravity.google/use-cases/frontend

「Antigravity」はブラウザ操作を含めた処理の流れが標準で組み込まれていることが、他のエディタの設計の思想が大きく変わってくるところかなと思います。

Webサイト制作で人間が行なっているワークフロー(エディタで実装して、ブラウザで表示、操作確認の流れ)AIエージェントが担ってくれるようになり、人間はその作業結果の評価をする、という動き方ができるようになりました。

Chrome DevTools MCP的な動きというよりは、どちらかというとブラウザの操作や表示内容の確認がメインの用途になる印象でした。

Chrome拡張機能の追加

AIエージェントがブラウザを利用するには拡張機能が必要になります。基本的には初回に利用する際にインストールが求められるはずなので手順に沿ってインストールしましょう。

スクリーンショットに結果に対して具体的なフィードバックができる

AIエージェントはタスク完了後にウォークスルー(Walkthrough)という成果物を作成します。

このウォークスルーには、エージェントが行った変更内容や検証ステップに加えて、ブラウザ操作のスクリーンショットや画面記録が含まれています。

参考:https://antigravity.google/docs/walkthrough

Visual Artifacts

The Agent is able to take screenshots and videos of its work in the browser so that you can see the results of the work asynchronously.

(日本語訳)

ビジュアルアーティファクト

エージェントはブラウザ上で作業のスクリーンショットや動画を撮影できるため、非同期で作業結果を確認できます。

引用:https://antigravity.google/use-cases/frontend

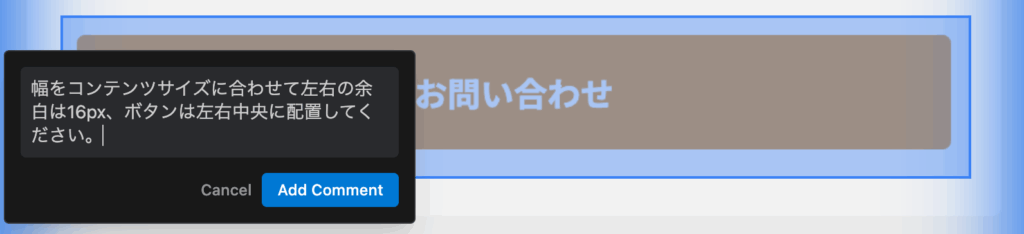

人間は、AIの作業した結果のスクリーンショットに対してコメントすることができます。体験としては隣で指差ししながら具体的なフィードバックができるような感覚で、スクリーンショットの具体的な箇所をドラッグしてコメントを残して再度依頼することが可能になっています。

Visual Feedback

You are able to leave visual comments on the visual Artifacts, making it simple to provide specific targeted feedback to the Agent.

(日本語訳)

ビジュアルフィードバック

ビジュアルアーティファクトにビジュアルコメントを残すことができるため、エージェントに具体的なフィードバックを簡単に提供できます。

「Nano Banana Pro」による画像生成

Gemini 3や、Google Antigravityと同時期にリリースされた「Nano Banana Pro」にAIエージェントが直接アクセスすることが可能になっています。

Gemini 3 Proのモデルを選択した時だで利用できるはずです。

基本的な仕様

利用できるモデル

以下のモデルが利用可能です。

- Gemini 3 Pro (high)

- Gemini 3 Pro (low)

- Claude Sonnet 4.5

- Claude Sonnet 4.5 (thinking)

- GPT-OSS

料金体系

現時点(2025年11月)では、無料版のみ利用可能なようです。

At this moment, Google Antigravity is only available as a no-cost public preview.

(日本語訳)

現時点では、Google Antigravity は無料のパブリックプレビューとしてのみご利用いただけます。

引用:https://antigravity.google/docs/plans

Gemini 3 Proの利用制限も「寛大なレート制限」ということで、試す分には十分に利用できるのかと思います。

以下のPricingページを見ると、チームプランやエンタープライズプランは近日公開ということのようです。

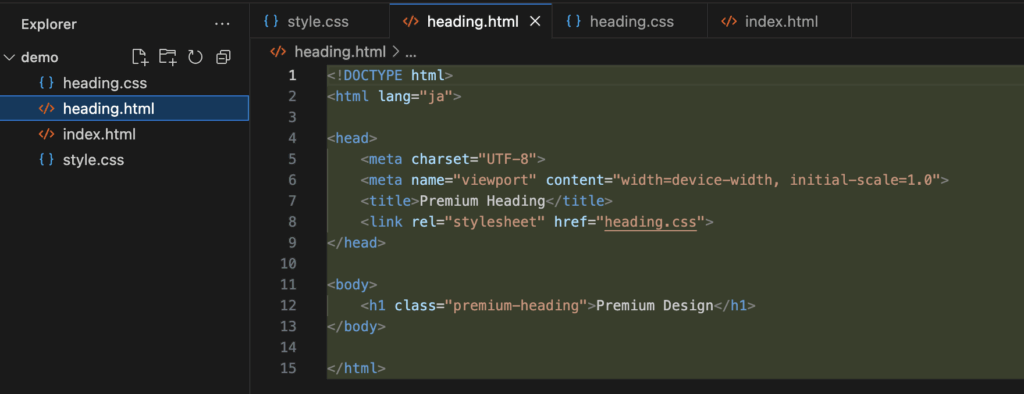

見栄え

見栄えはVS Codeをシュッとした印象です。標準だと左から以下のような並びでVS Codeに馴染んでいる方は違和感なく触れるのかなと思います。

- Activity Bar(Explorerや拡張機能などのアイコン)

- Side Bar

- Editor

- Agent

拡張機能

インストールできる拡張機能は「Open VSX Registry」というマーケットプレイスで管理されていそうです。

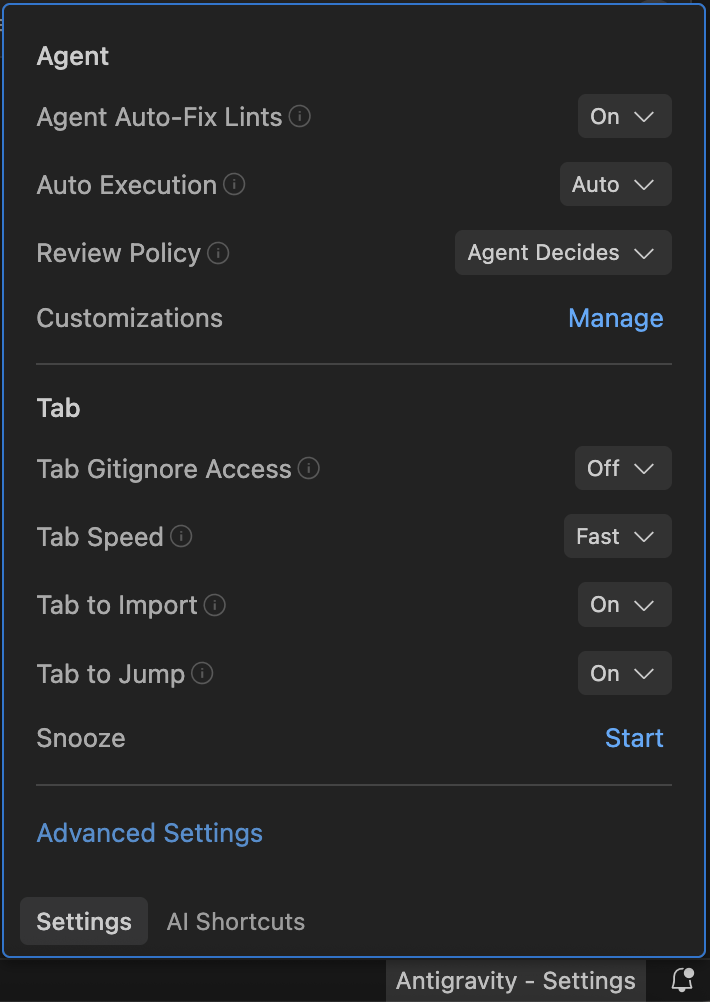

AIエージェントへのルールの追加

右下の「Antigravity – Settings」の「Manage」から追加できます。ここはWindsurfみがある。

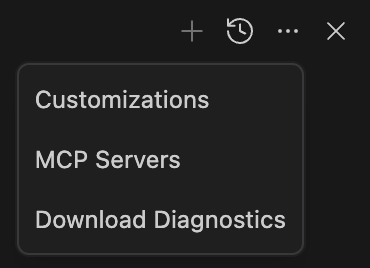

MCPサーバーの設定

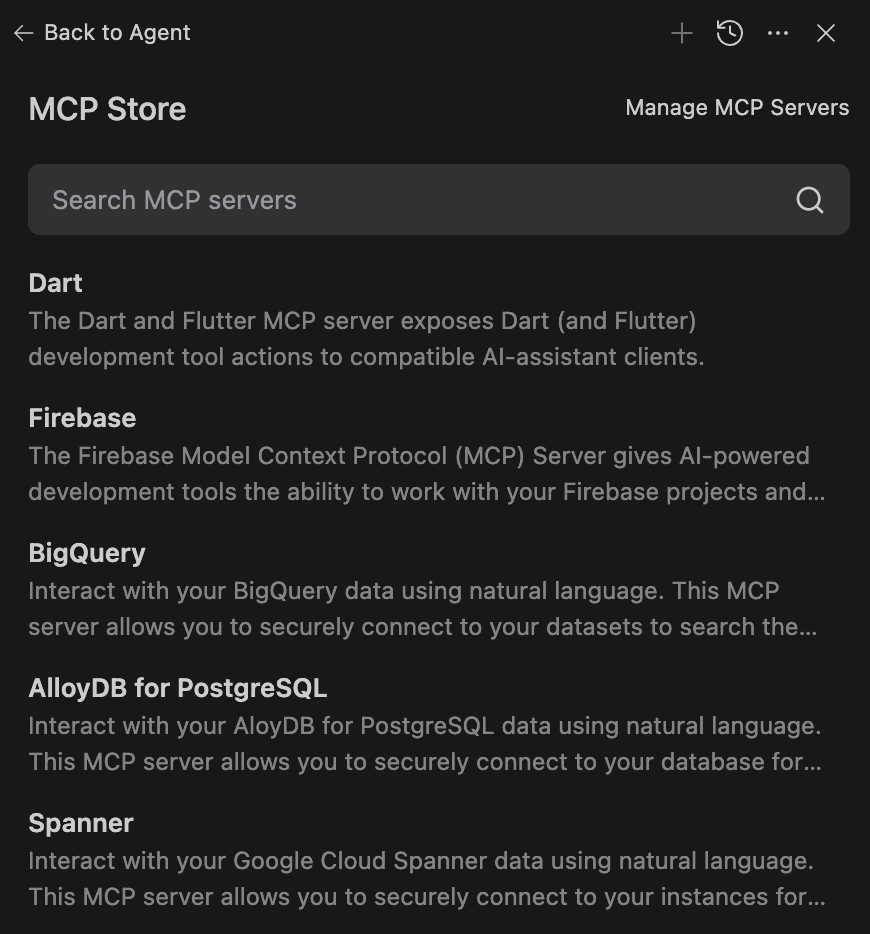

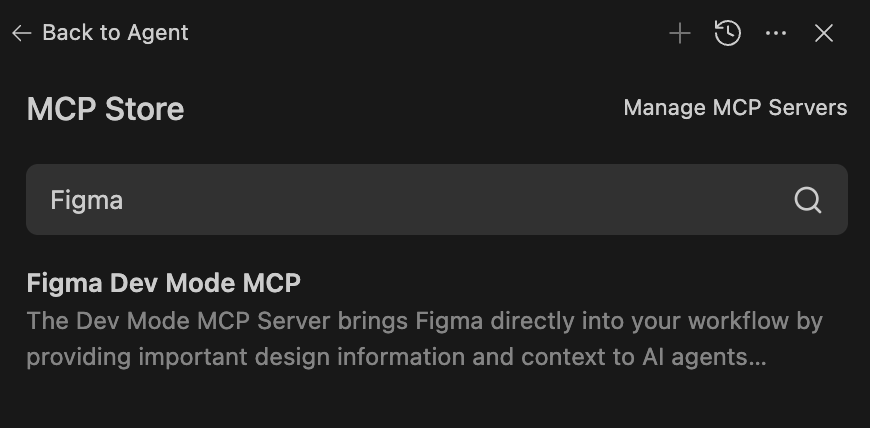

MCPサーバーはAgentパネルから追加できそうです。

MCP Storeから簡単に導入することができそうです。

選択できるMCPサーバーの一覧が並びます。

検索すると「Figma Dev Mode MCP」もありました。

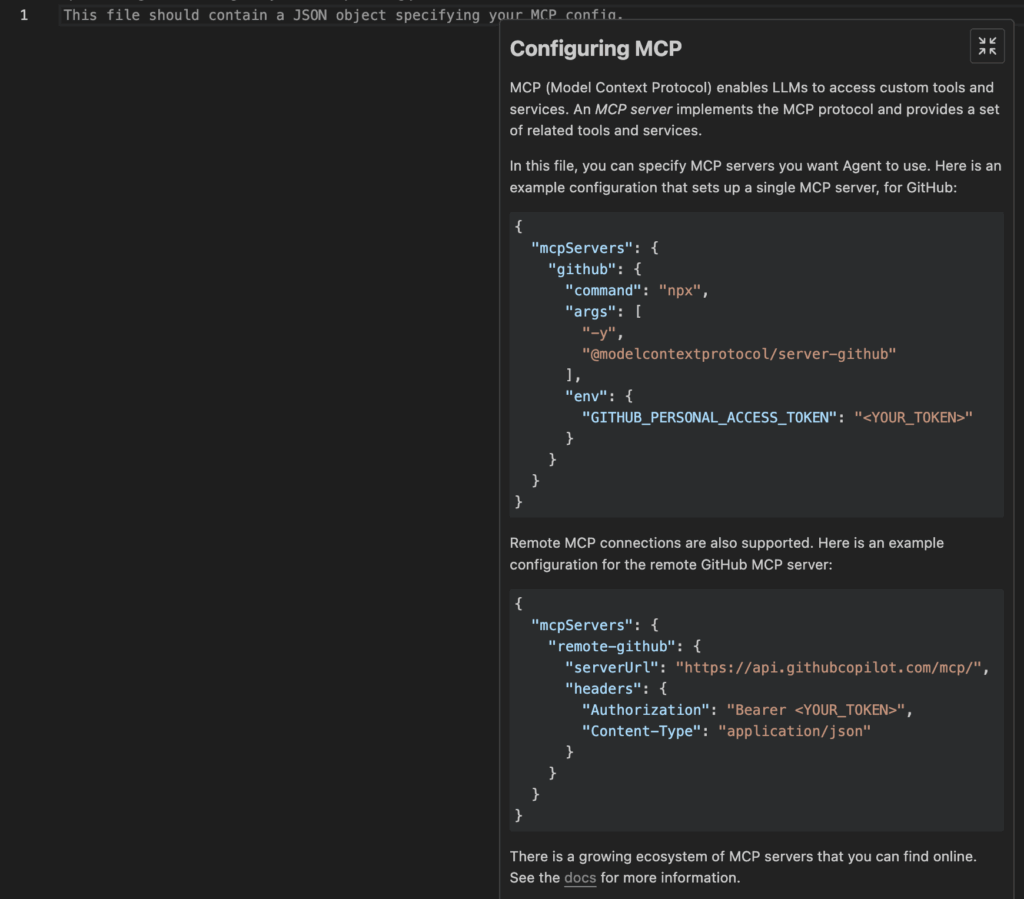

独自で追加する場合は、右上の「Manage MCP Servers」から直接設定が可能です。パスとしては次の場所でした。~/.gemini/antigravity/mcp_config.json

(WindsurfのUIもこんな感じだった気がする)

「Gemini 3 Pro」の性能について

Google Antigravityの紹介からは少しズレますが、Webサイト制作で「Gemini 3 Pro」によってもたらされる恩恵はおそらく「長文読解力」「画像理解」の性能の高さによる所なのかなと思います。

事例は局所的な内容かもしれませんが、自分の理解の延長線上としての気づきになります。

長文読解力

長文読解力は「多くのコンテキストを解釈して論理的に処理する力」というイメージで解釈していますが、Gemini 3 Proはこの能力が高いそうです。

今のWeb制作のフローとして、Figma MCP登場によって「FigmaのデザインデータをAIが解釈して実装する」が可能になりました。とはいえAIがデザインカンプ通りに完璧に実装してくれるわけではありません。

いろんな理由があると思いますが、1つはAIが理解できるコンテキストの限界があるのかなと思っています。Figmaのたくさんの構造を渡しすぎるとAIが全てを理解できず構造の整合性が取れないまま実装しているような気がしています。

なので、AIが理解しやすい単位で細かく区切って依頼するという流れを取っていましたが、Gemini 3 Proになると、Figmaの情報をたくさん渡しても理解しきれるようになりました。

画像理解

画像の内容を解釈する力が強いと言われています。「画像の通りに実装してください」はあまり現実的に利用することはできませんでした。

ただ、Gemini 3 Proでは画像の内容を理解できる力が強いので、画像の内容を読み取って正確に実装することが可能になります。

Web制作者が受ける恩恵としては、

- 画像から実装してもらえる

- 完成系の画像を渡して調整してもらえる

ということかなと思います。

画像から実装してもらえる

画像から実装はシンプルに、「この画像を参考に実装してください」と依頼した時に高い精度が期待できる、ということかなと思います。

Figma Dev Mode MCPを使う場合は、get_screenshotのツールと相性が良さそう。

完成系の画像を渡して調整してもらえる

こちらは、実装結果と完成系の画像を比較して調整が可能ということです。イマイチな出力だった場合は、完成系の画像を共有することで調整してもらいやすくなるかと思います。

Gemini 3 Proの強みである、長文読解力と画像理解を組み合わせると、より人間が意図した通りの実装をAI自身が行ってくれるのではないかなと思っています。

MRCR v2やScreenSpot-Proの指標は、以下の動画から学びでした(解釈がずれていたらすみません🙇♂️)

試してみる

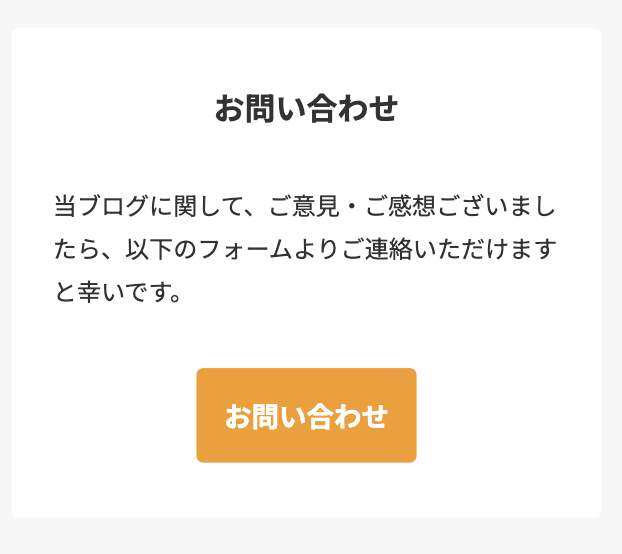

実際にGemini 3 Proを活用して実装をお願いしてます。元となるのはFigmaのデザインカンプです(簡単)

依頼内容としては以下の通りです。Figma Dev Mode MCPを使っています。

PC:

https://www.figma.com/design/xxxxx

スマホ:

https://www.figma.com/design/xxxxx

Figma MCPを使ってHTMLとCSSでデザインカンプを忠実に再現してください。

@figma.md を必ず最初に読み込むこと。GPT-5.1 Codexの場合

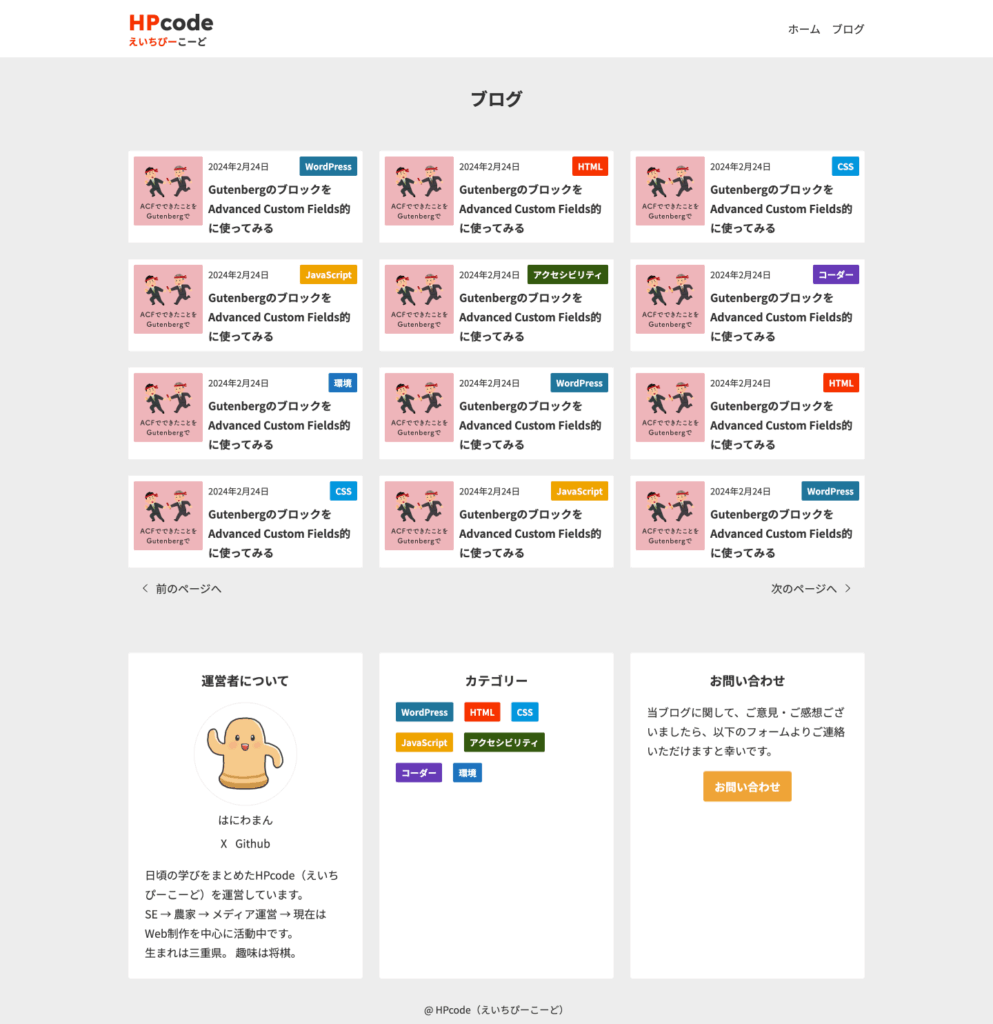

結構近い。

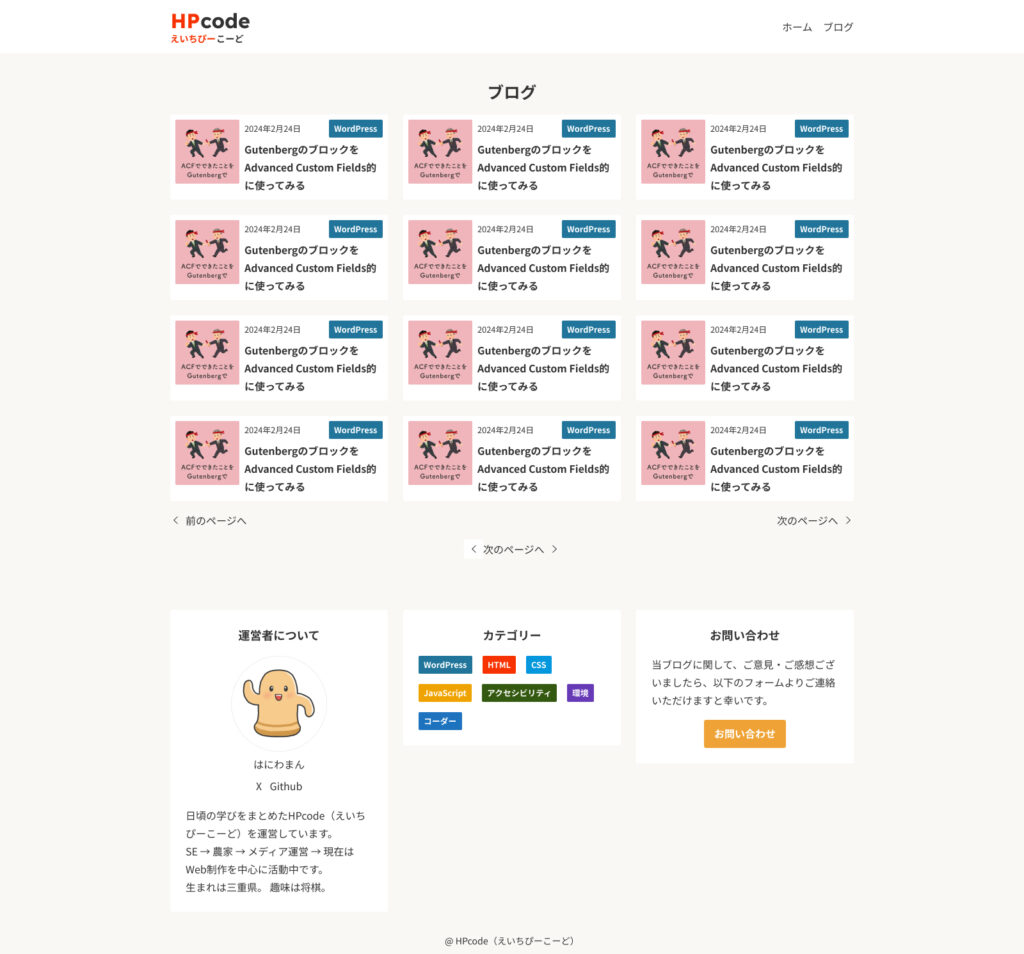

Claude Sonnet 4.5の場合

かなり完成度が高いです。少し色やラベルが違いそうですが構造はほとんど反映されているように思います。

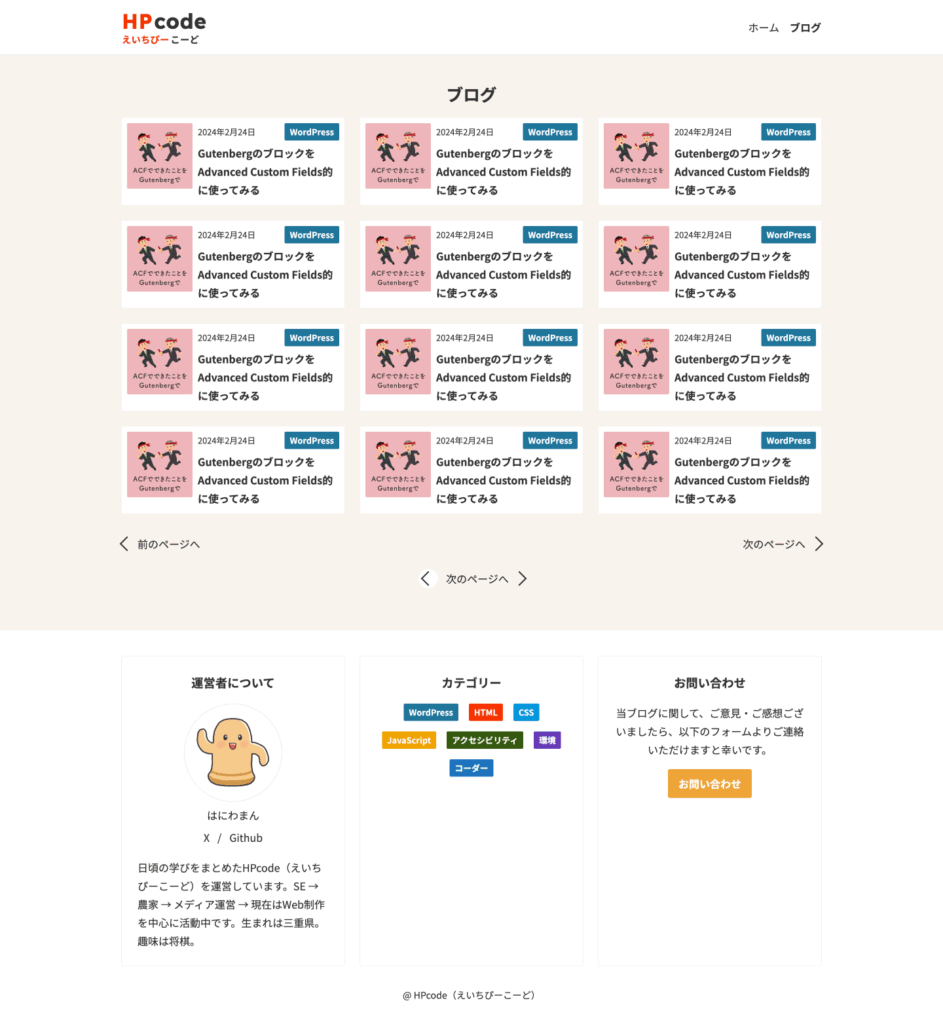

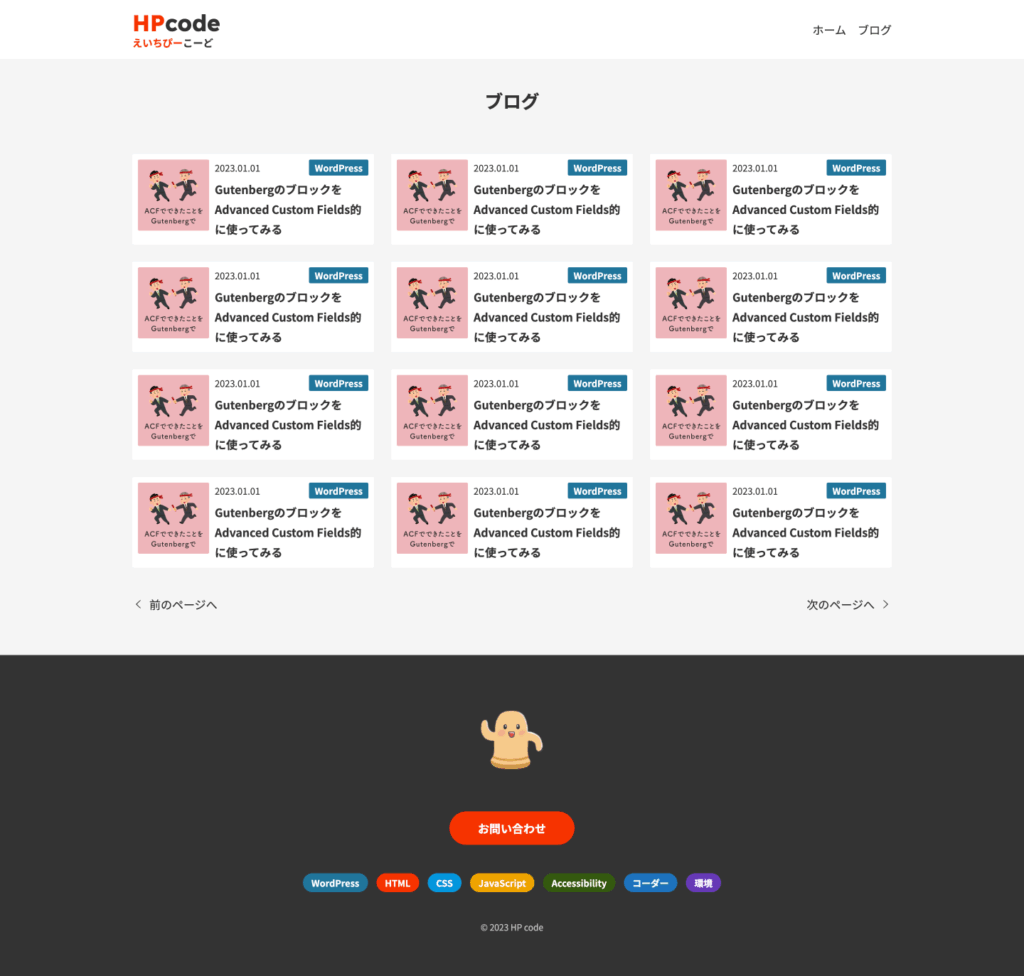

Gemini 3 Proの場合

Gemini 3 Proがもっとも精度が高い、という流れになるのかなと思いましたが、フッターが全然違う…。

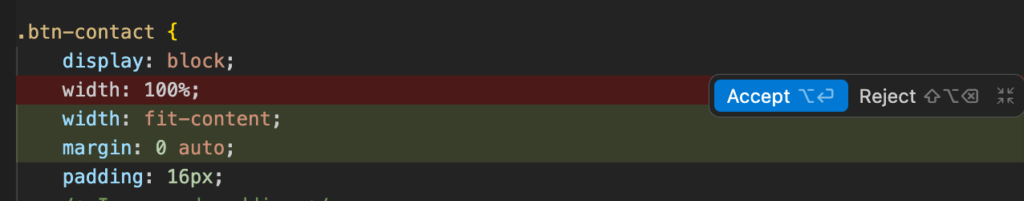

完成系の画像を渡して調整してもらうパターンを試してみました。

Gemini 3 Proに完成画像を渡してみた

フッターが生まれ変わりました。画像を理解する力は強いかもしれません。

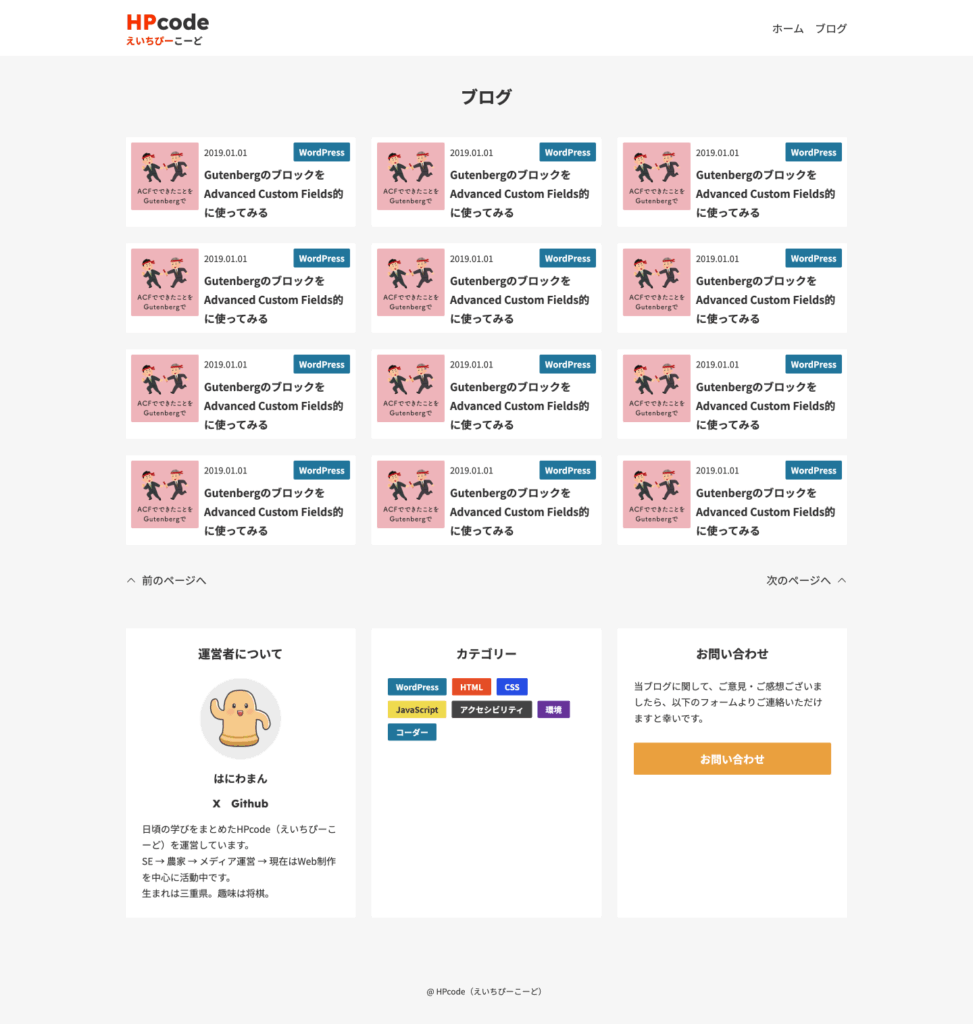

スクリーンショットから修正依頼もしてみる

Antigravityの特徴として結果のスクリーンショットからピンポイントで修正依頼を出すことが可能なので試してみます。

該当箇所だけ修正されていそうです。

おわりに

GoogleのAIコードエディタ「Antigravity」について特徴をまとめと動作の確認をしました。特徴としては以下のあたりなのかなと思います。

- 並列タスク実行と独立したAgent Manager

- AIエージェントがブラウザを操作してテスト

- スクリーンショットに結果に対して具体的なフィードバック

SNSでの盛り上がり方を見ていて局所的な使い方のような気はしますが、まずは今まで試したことある中での延長線上で「Google Antigravity」と「Gemini 3 Pro」を確認してみました。

正直なところとしては、同じモデルでもCursorで依頼した方が精度が高くなる傾向はあるかもしれません。これがなぜかは分かりません…。

とはいえ、ブラウザでの確認やピンポイントのでフィードバックなど他のAIエディタにはない特徴がありますし、Antigravityの使用感は個人的には使いやすいです。少しの間はGoogle Antigravityを使って慣れていけたらと思います。